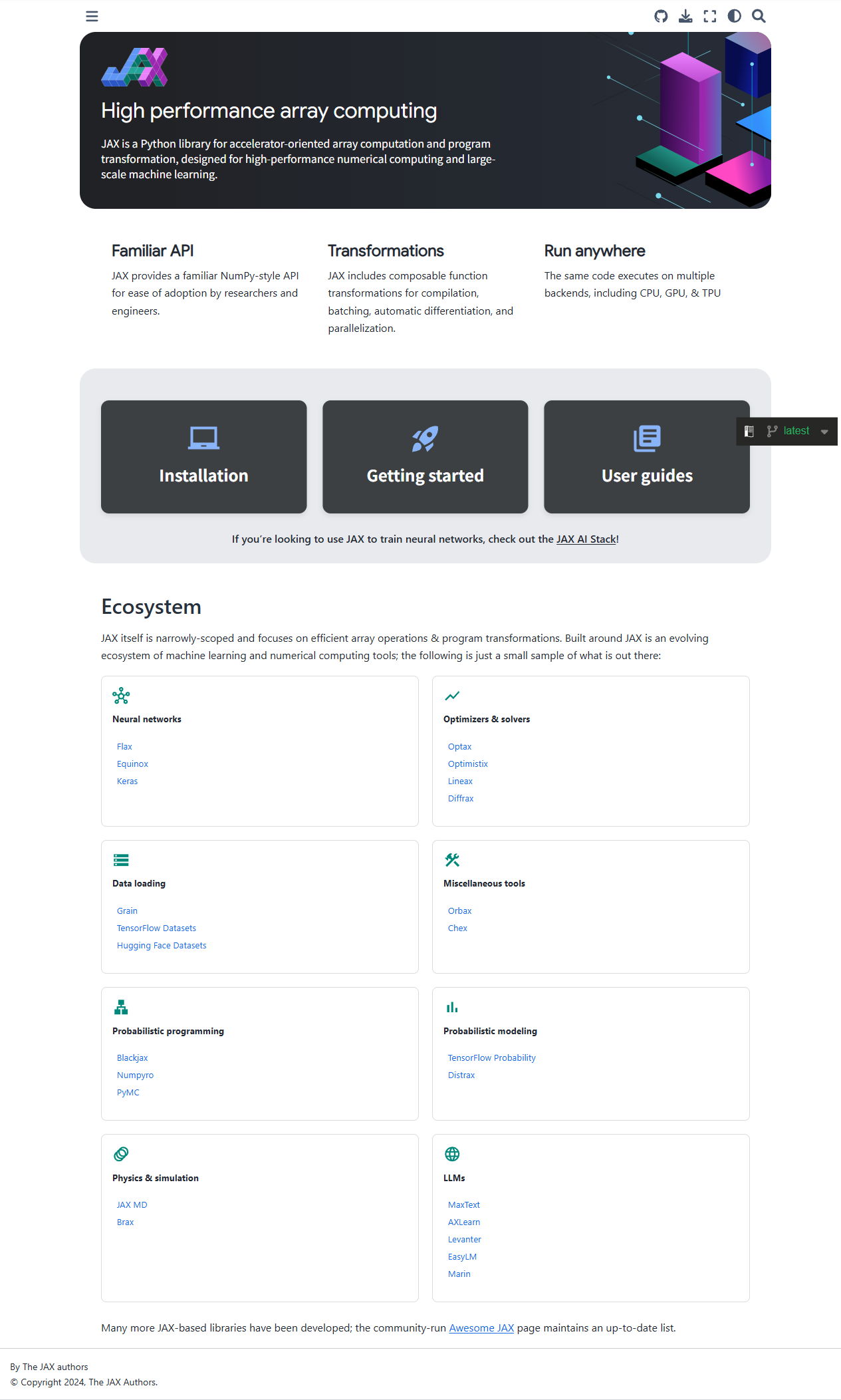

JAX官方文档是谷歌开源项目JAX的权威门户,围绕“NumPy+Autograd+XLA”三大核心,提供从安装、快速上手到深度优化的全流程指引。内容覆盖基础API、即时编译(JIT)、自动微分、向量化/并行化、随机数、调试技巧及生态扩展(如Flax、Optax)。文档以交互式Notebook示例为主,辅以性能分析、迁移指南与常见问题,帮助研究者和工程师在CPU/GPU/TPU上高效实现科学计算、机器学习及深度学习任务。

JAX官方文档是谷歌开源项目JAX的权威门户,围绕“NumPy+Autograd+XLA”三大核心,提供从安装、快速上手到深度优化的全流程指引。内容覆盖基础API、即时编译(JIT)、自动微分、向量化/并行化、随机数、调试技巧及生态扩展(如Flax、Optax)。文档以交互式Notebook示例为主,辅以性能分析、迁移指南与常见问题,帮助研究者和工程师在CPU/GPU/TPU上高效实现科学计算、机器学习及深度学习任务。

jax.numpy几乎无缝替换NumPy,支持高维数组、广播、线性代数、FFT等,且可在GPU/TPU上零改动运行。 grad、value_and_grad、hessian、jacfwd/jacrev等变换支持任意阶导数,兼容Python控制流(循环、条件、递归)。 @jit将Python函数编译为XLA优化内核,融合算子、消除Python开销,实现数十倍加速;pjit支持多设备并行。 vmap自动批处理,pmap实现多加速器数据并行,shard_map细粒度手动分片。 jax.random提供可复现、可分叉的PRNGKey机制,避免全局状态。 jax.lax.scan、jax.checkpoint管理循环与内存,携带状态的纯函数模式(如flax.nn.Module)。 jax.profiler生成TensorBoard或Chrome Trace,定位瓶颈;jax.debug系列工具实时打印中间值。