LLaMA(Large Language Model Meta AI)是Meta于2023年2月发布的基础大语言模型系列,参数规模7B–65B。官网仓库托管在GitHub facebookresearch/llama,提供完整源码、权重申请脚本、推理示例、LoRA微调示例及社区贡献的llama-recipes。模型仅用公开数据训练,遵循非商业研究许可,可在单张A100 80G GPU或更小的消费级显卡上运行,实现接近GPT-3的效果,为研究者和开发者提供可复现、可扩展的开源基座。

LLaMA(Large Language Model Meta AI)是Meta于2023年2月发布的基础大语言模型系列,参数规模7B–65B。官网仓库托管在GitHub facebookresearch/llama,提供完整源码、权重申请脚本、推理示例、LoRA微调示例及社区贡献的llama-recipes。模型仅用公开数据训练,遵循非商业研究许可,可在单张A100 80G GPU或更小的消费级显卡上运行,实现接近GPT-3的效果,为研究者和开发者提供可复现、可扩展的开源基座。

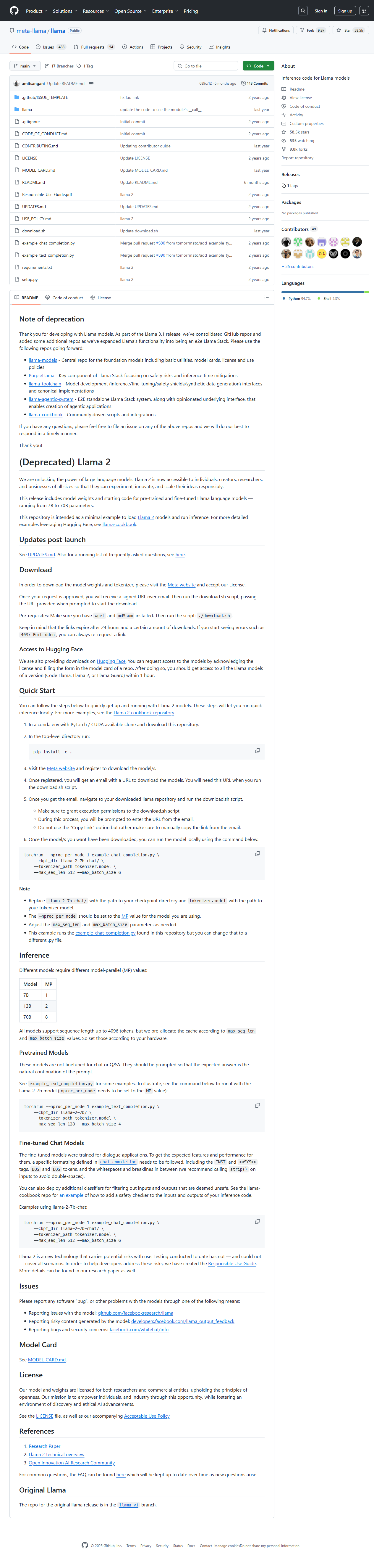

download.sh脚本,填写Meta邮件中的签名URL即可一键拉取7B/13B/30B/65B四档模型;含SHA256校验,防止篡改。 example.py支持PyTorch原生加载,可指定--max-seq-len、--temperature等参数,快速体验文本续写、问答。 llama-recipes子仓库内置HuggingFace PEFT、bitsandbytes 4-bit量化方案,单卡8G显存即可微调,附Samsum对话数据集示例。 LlamaForCausalLM接口。