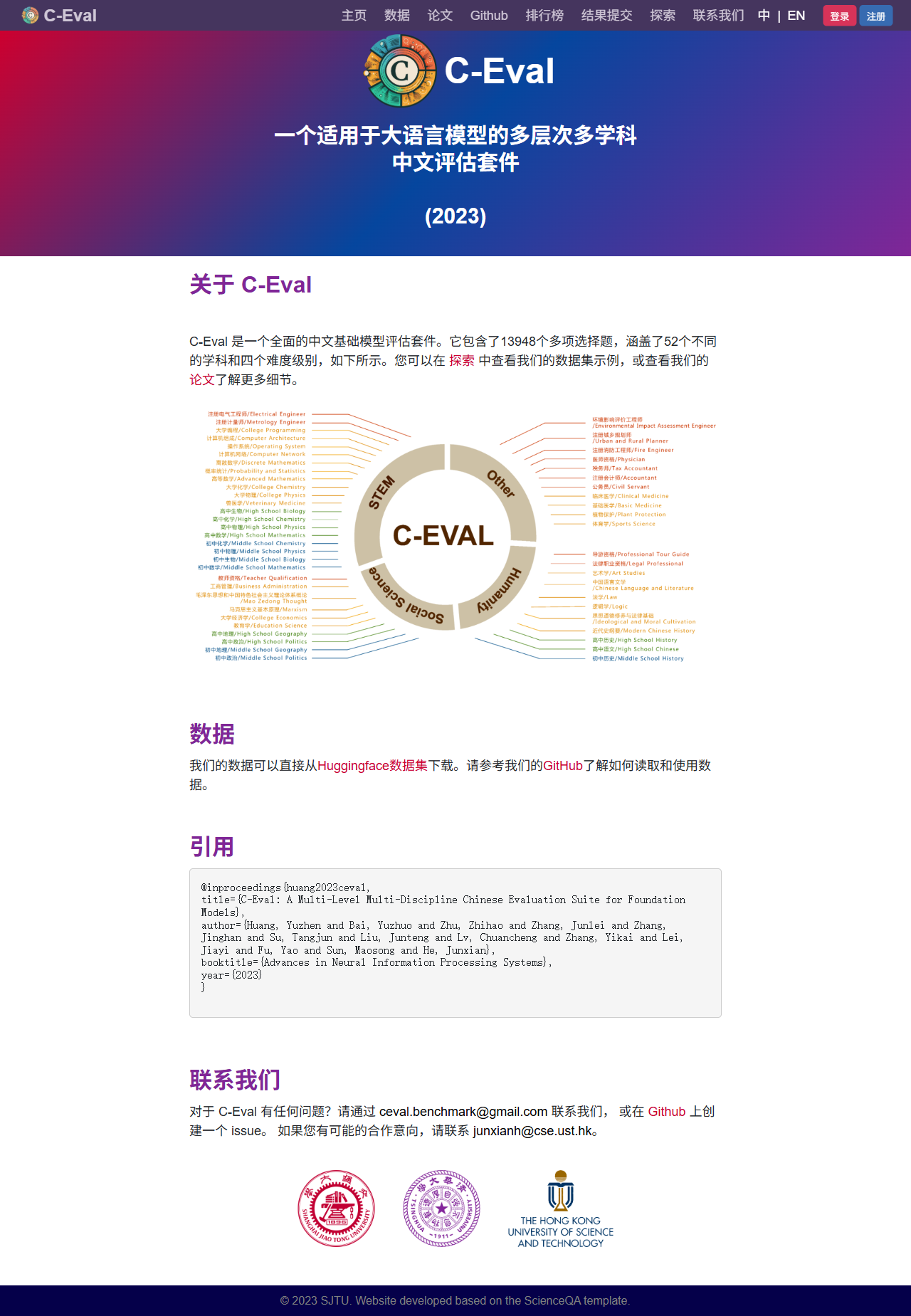

C-Eval(https://cevalbenchmark.com/index_zh.html)是面向中文大语言模型的权威评测平台,由清华大学、上海交大、复旦等多所高校联合发起。它通过覆盖52个学科、13948道四档难度选择题,全面检验模型在人文、社科、理工、医学等领域的知识深度与推理能力。平台实时更新排行榜,公开评测方法与数据,为研究者、企业与开发者提供统一、可复现的能力标尺,助力中文大模型技术透明与进步。

C-Eval(https://cevalbenchmark.com/index_zh.html)是面向中文大语言模型的权威评测平台,由清华大学、上海交大、复旦等多所高校联合发起。它通过覆盖52个学科、13948道四档难度选择题,全面检验模型在人文、社科、理工、医学等领域的知识深度与推理能力。平台实时更新排行榜,公开评测方法与数据,为研究者、企业与开发者提供统一、可复现的能力标尺,助力中文大模型技术透明与进步。

• 高校与实验室:发表中文大模型论文前,用C-Eval结果作基准数据。

• 企业算法团队:上线客服、教育、医疗等场景前,验证模型是否达标。

• 投资者与媒体:快速查看排行榜,评估初创公司模型实力。

• 开发者:调试微调模型时,利用API持续监控性能变化。

• 政策制定者:获取行业整体水平报告,作为技术治理依据。

• 学科最全面:52门中文科目,文理医工全覆盖。

• 难度分级:四档递进,精准衡量模型“天花板”。

• 公开透明:题库、脚本、评分逻辑完全开源,可复现。

• 零门槛:网页上传即可获得权威报告,无需自建环境。

• 社区共治:规则由学界、工业界共同迭代,持续进化。