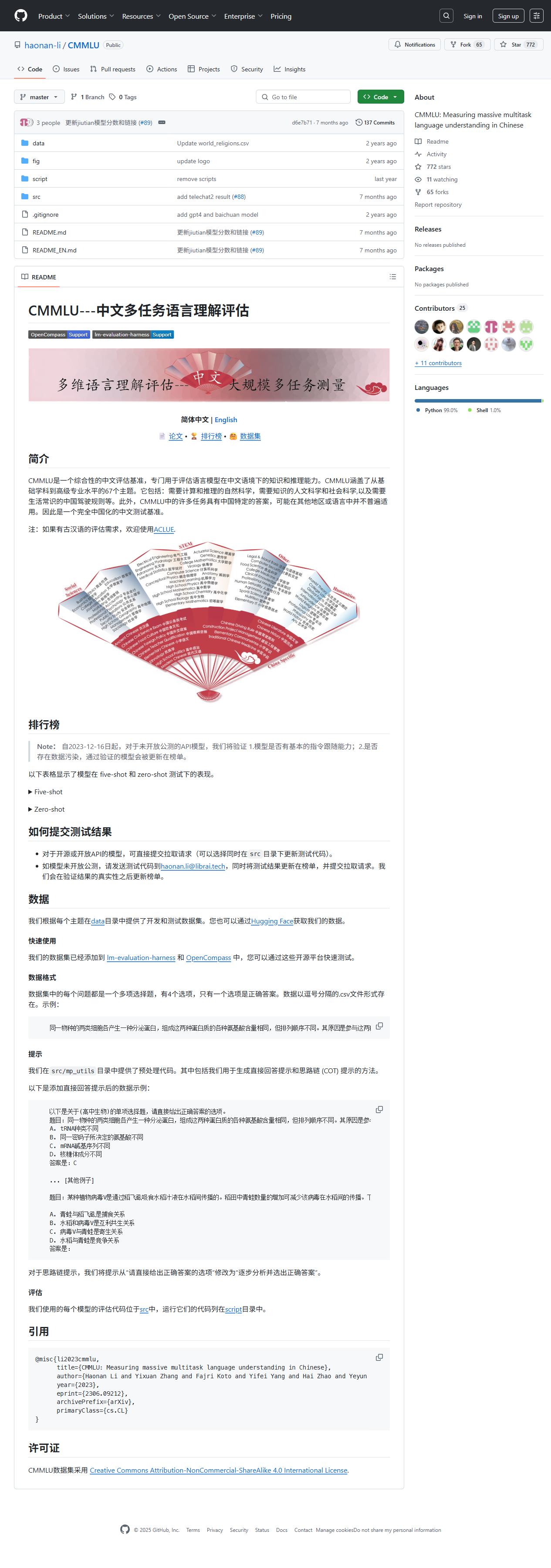

CMMLU 由 Li Haonan 等人维护,是一个面向中文语境的大规模多任务语言理解基准。它收录 11 528 道四选一单选题,覆盖 67 个学科——从 STEM、人文社科到中国驾驶规则、传统文化,难度横跨小学到专家级。项目公开排行榜、数据集下载、评估脚本及论文,支持零样本与五样本测试,帮助研究者快速比较不同规模、不同架构的大模型在中文知识、推理与文化常识上的真实水平。

CMMLU 由 Li Haonan 等人维护,是一个面向中文语境的大规模多任务语言理解基准。它收录 11 528 道四选一单选题,覆盖 67 个学科——从 STEM、人文社科到中国驾驶规则、传统文化,难度横跨小学到专家级。项目公开排行榜、数据集下载、评估脚本及论文,支持零样本与五样本测试,帮助研究者快速比较不同规模、不同架构的大模型在中文知识、推理与文化常识上的真实水平。

• 研究:高校与实验室发表中文大模型论文时,用 CMMLU 作为权威基准。

• 工业:企业在选型阶段,快速对比自研与商用模型在目标行业的知识能力。

• 教育:AI 课程作业,让学生体验少样本学习、提示工程。

• 竞赛:黑客松、算法大赛以 CMMLU 为赛题,考验模型中文推理极限。

• 监管:第三方机构评估大模型合规性,检测涉政、法律、医学等敏感领域盲点。

• 中文专属:题目根植本土文化,避免翻译偏差。

• 学科最全:67 门学科一次测遍,减少拼凑多数据集的麻烦。

• 双模式评估:零样本测泛化,五样本测小样本适应性。

• 开放透明:题库、脚本、榜单全开源,结果可复现。

• 社区活跃:论文作者直接维护,Issue 平均 24h 内响应。

• 易用:十分钟完成首次评估,支持 Colab 一键跑通。